在本教程中,我们将使用 OpenAI SDK 构建一个简单的 RAG 应用程序。我们将在开发的每个阶段(从原型到生产)向应用程序添加可观测性。

from openai import OpenAI

openai_client = OpenAI()

# This is the retriever we will use in RAG

# This is mocked out, but it could be anything we want

def retriever(query: str):

results = ["Harrison worked at Kensho"]

return results

# This is the end-to-end RAG chain.

# It does a retrieval step then calls OpenAI

def rag(question):

docs = retriever(question)

system_message = """Answer the users question using only the provided information below:

{docs}""".format(docs="\n".join(docs))

return openai_client.chat.completions.create(

messages=[

{"role": "system", "content": system_message},

{"role": "user", "content": question},

],

model="gpt-4o-mini",

)

原型设计

从一开始就设置可观测性可以帮助您比原本能够更快地迭代。它允许您在快速迭代提示或更改您正在使用的数据和模型时对应用程序有很好的可见性。在本节中,我们将介绍如何设置可观测性,以便在原型设计时获得最大的可观测性。

设置您的环境

首先,通过导航到设置页面创建 API 密钥。

接下来,安装 LangSmith SDK:

最后,设置适当的环境变量。这会将跟踪记录到 default 项目(尽管您可以轻松更改)。

export LANGSMITH_TRACING=true

export LANGSMITH_API_KEY=<your-api-key>

export LANGSMITH_WORKSPACE_ID=<your-workspace-id>

export LANGSMITH_PROJECT=default

您可能在其他地方看到这些变量被引用为 LANGCHAIN_*。这些都是等效的,但最佳实践是使用 LANGSMITH_TRACING、LANGSMITH_API_KEY、LANGSMITH_PROJECT。LANGSMITH_PROJECT 标志仅在 JS SDK 版本 >= 0.2.16 中受支持,如果您使用的是较旧版本,请改用 LANGCHAIN_PROJECT。

跟踪您的 LLM 调用

您可能想要跟踪的第一件事是所有 OpenAI 调用。毕竟,这是实际调用 LLM 的地方,所以这是最重要的部分!我们通过引入一个非常简单的 OpenAI 包装器,尝试使 LangSmith 尽可能简单。您只需要修改代码,使其看起来像这样:

from openai import OpenAI

from langsmith.wrappers import wrap_openai

openai_client = wrap_openai(OpenAI())

# This is the retriever we will use in RAG

# This is mocked out, but it could be anything we want

def retriever(query: str):

results = ["Harrison worked at Kensho"]

return results

# This is the end-to-end RAG chain.

# It does a retrieval step then calls OpenAI

def rag(question):

docs = retriever(question)

system_message = """Answer the users question using only the provided information below:

{docs}""".format(docs="\n".join(docs))

return openai_client.chat.completions.create(

messages=[

{"role": "system", "content": system_message},

{"role": "user", "content": question},

],

model="gpt-4o-mini",

)

from langsmith.wrappers import wrap_openai 并使用它来包装 OpenAI 客户端(openai_client = wrap_openai(OpenAI()))。

如果您以以下方式调用它会发生什么?

rag("where did harrison work")

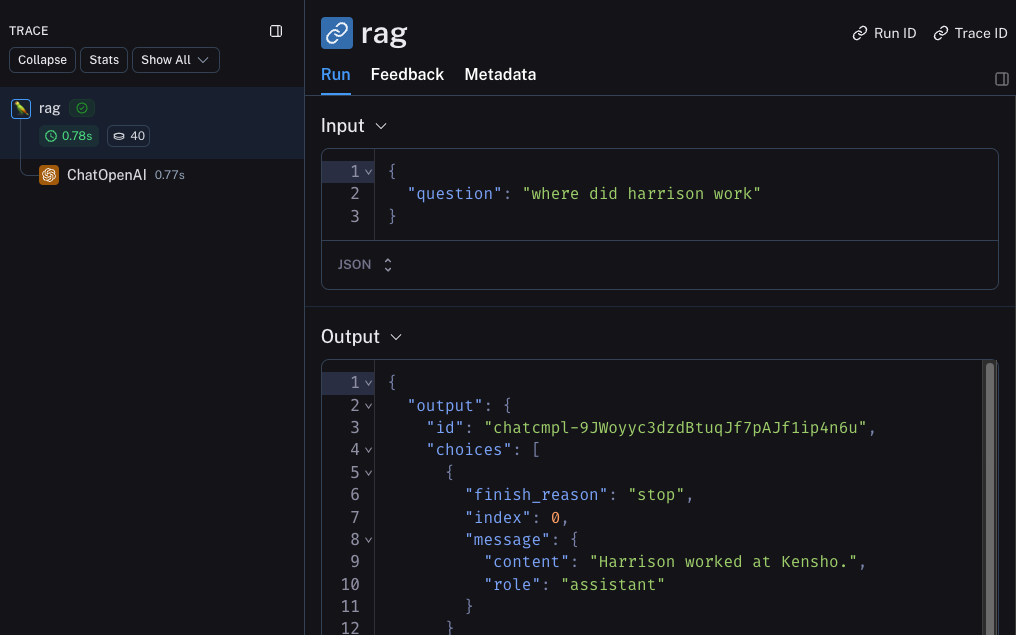

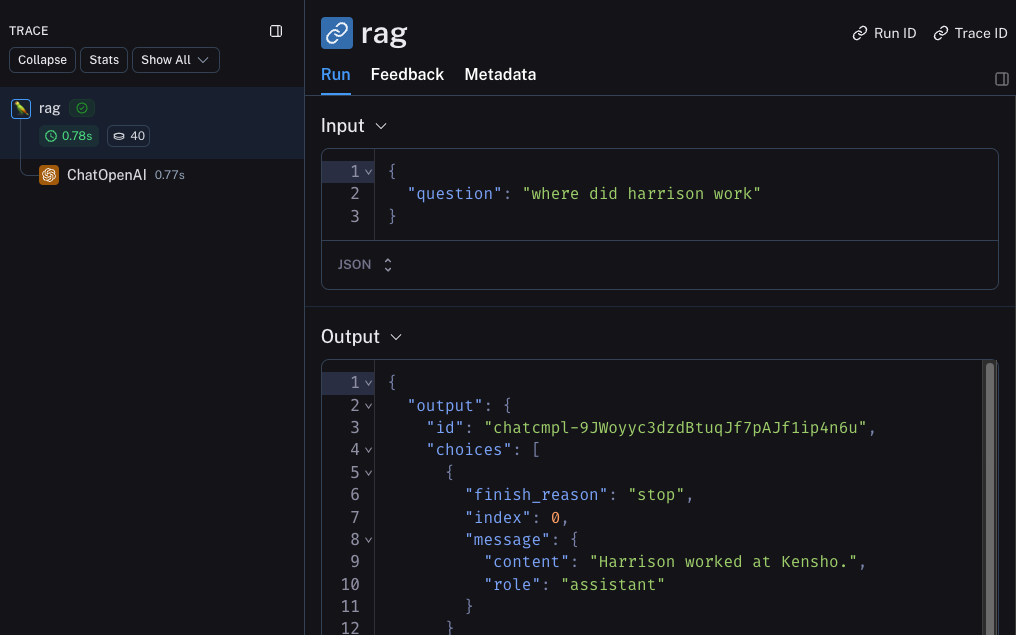

跟踪整个链

很好 - 我们已经跟踪了 LLM 调用。但通常跟踪更多内容会非常有信息量。LangSmith 专为跟踪整个 LLM 管道而构建 - 所以让我们这样做!我们可以通过修改代码使其现在看起来像这样:

from openai import OpenAI

from langsmith import traceable

from langsmith.wrappers import wrap_openai

openai_client = wrap_openai(OpenAI())

def retriever(query: str):

results = ["Harrison worked at Kensho"]

return results

@traceable

def rag(question):

docs = retriever(question)

system_message = """Answer the users question using only the provided information below:

{docs}""".format(docs="\n".join(docs))

return openai_client.chat.completions.create(

messages=[

{"role": "system", "content": system_message},

{"role": "user", "content": question},

],

model="gpt-4o-mini",

)

from langsmith import traceable 并使用它来装饰整体函数(@traceable)。

如果您以以下方式调用它会发生什么?

rag("where did harrison work")

Beta 测试

LLM 应用程序开发的下一个阶段是对您的应用程序进行 beta 测试。这是当您将其发布给一些初始用户时。在这里设置良好的可观测性至关重要,因为通常您不知道用户实际上会如何使用您的应用程序,因此这允许您深入了解他们如何这样做。这也意味着您可能想要对跟踪设置进行一些更改以更好地允许这样做。这扩展了您在前一节中设置的可观测性

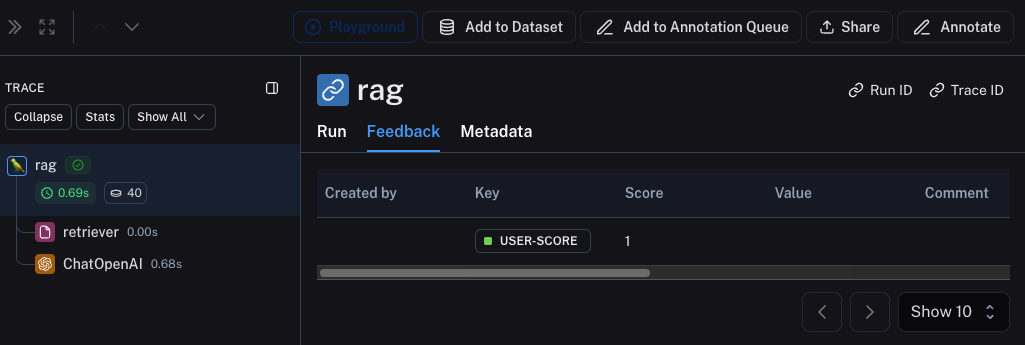

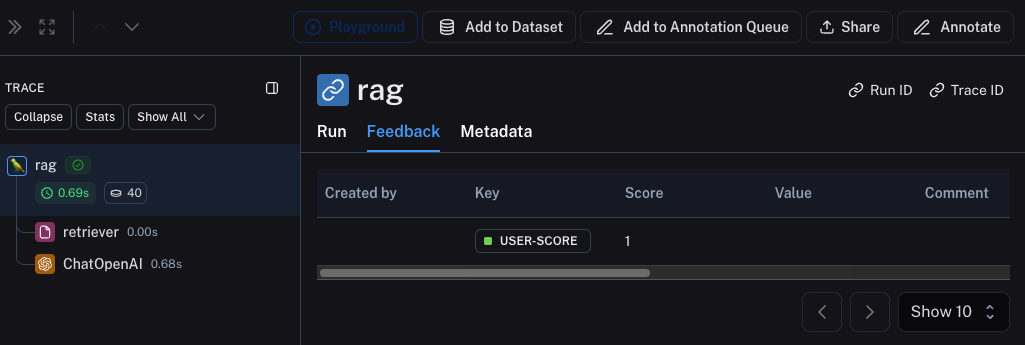

收集反馈

在 beta 测试期间拥有良好可观测性的一个重要部分是收集反馈。您收集的反馈通常是特定于应用程序的 - 但至少一个简单的点赞/点踩是一个好的开始。记录该反馈后,您需要能够轻松地将其与导致该反馈的运行关联起来。幸运的是,LangSmith 使这变得容易。

首先,您需要从应用程序记录反馈。一个简单的方法是为每次运行跟踪一个运行 ID,然后使用它来记录反馈。跟踪运行 ID 看起来像这样:

import uuid

run_id = str(uuid.uuid4())

rag(

"where did harrison work",

langsmith_extra={"run_id": run_id}

)

from langsmith import Client

ls_client = Client()

ls_client.create_feedback(

run_id,

key="user-score",

score=1.0,

)

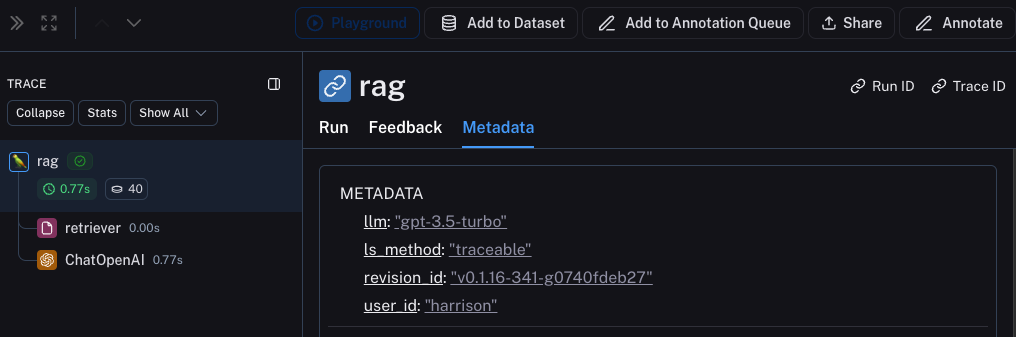

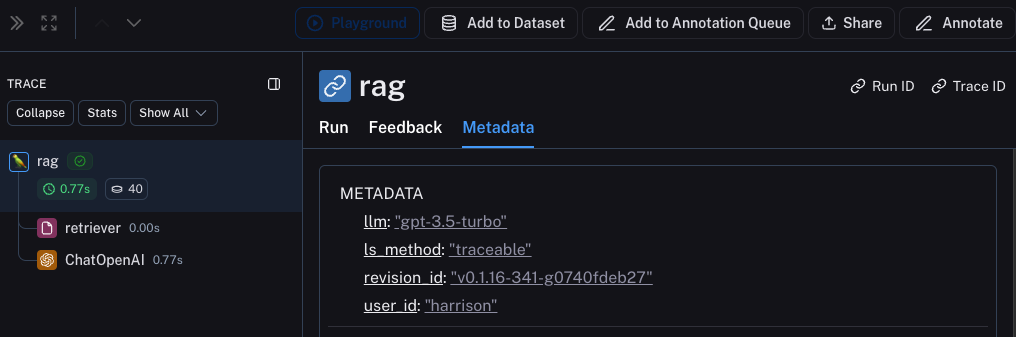

Metadata 选项卡来查看它与每次运行的关联。它应该看起来像这样

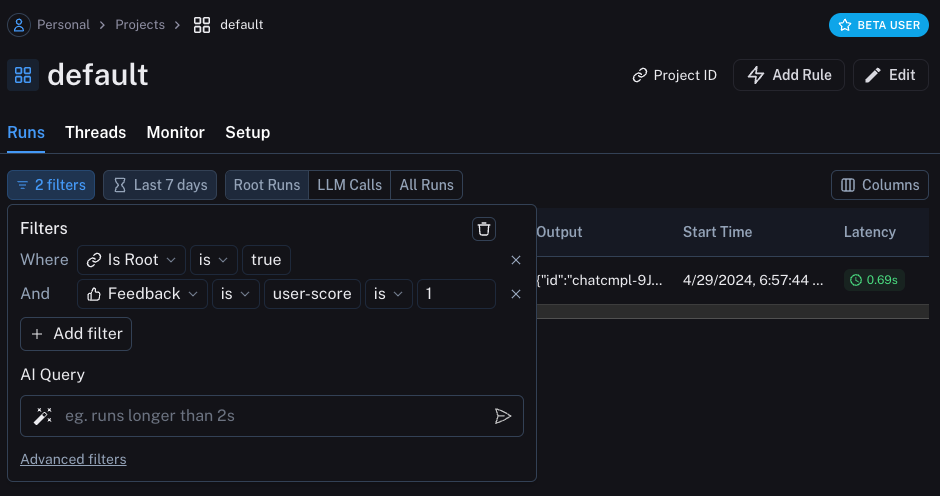

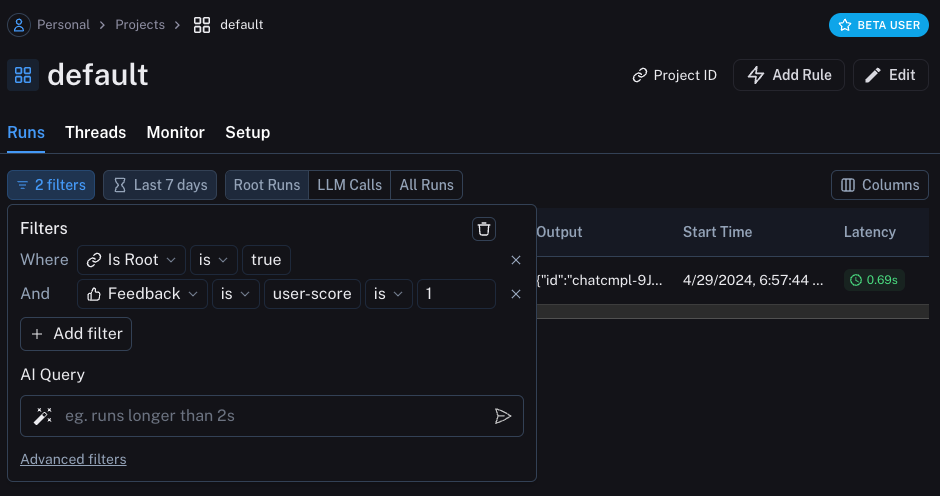

您还可以通过使用运行表中的过滤逻辑来查询所有具有正面(或负面)反馈的运行。您可以通过创建如下过滤器来做到这一点:

您还可以通过使用运行表中的过滤逻辑来查询所有具有正面(或负面)反馈的运行。您可以通过创建如下过滤器来做到这一点:

记录元数据

开始记录元数据也是一个好主意。这允许您开始跟踪应用程序的不同属性。这对于让您知道使用什么版本或变体的应用程序来产生给定结果很重要。

对于此示例,我们将记录使用的 LLM。通常您可能正在试验不同的 LLM,因此将该信息作为元数据对于过滤很有用。为了做到这一点,我们可以这样添加它:

from openai import OpenAI

from langsmith import traceable

from langsmith.wrappers import wrap_openai

openai_client = wrap_openai(OpenAI())

@traceable(run_type="retriever")

def retriever(query: str):

results = ["Harrison worked at Kensho"]

return results

@traceable(metadata={"llm": "gpt-4o-mini"})

def rag(question):

docs = retriever(question)

system_message = """Answer the users question using only the provided information below:

{docs}""".format(docs='\n'.join(docs))

return openai_client.chat.completions.create(messages = [

{"role": "system", "content": system_message},

{"role": "user", "content": question},

], model="gpt-4o-mini")

rag 函数中添加了 @traceable(metadata={"llm": "gpt-4o-mini"})。

以这种方式跟踪元数据假设它是提前已知的。这对于 LLM 类型来说很好,但对于其他类型的信息(如用户 ID)来说不太理想。为了记录该信息,我们可以在运行时通过运行 ID 传入它。

import uuid

run_id = str(uuid.uuid4())

rag(

"where did harrison work",

langsmith_extra={"run_id": run_id, "metadata": {"user_id": "harrison"}}

)

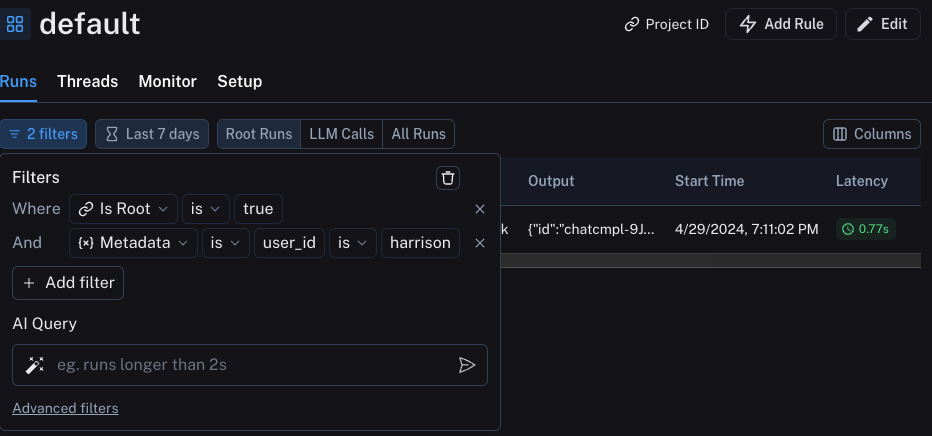

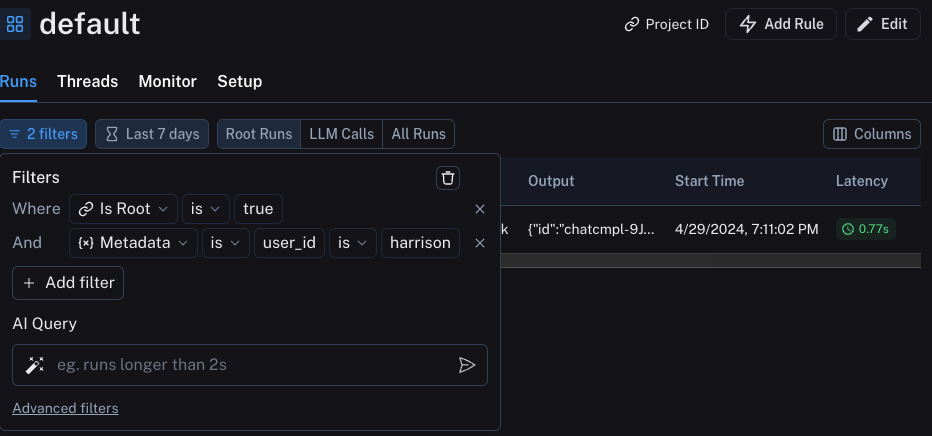

我们可以通过构建如下过滤器来过滤这些信息:

我们可以通过构建如下过滤器来过滤这些信息:

很好 - 您已经使用这种新发现的可观测性快速迭代,并对您的应用程序表现良好充满信心。是时候将其投入生产了!您需要添加什么新的可观测性?

首先,让我们注意,您已经添加的相同可观测性将继续在生产中提供价值。您将能够继续深入查看特定运行。

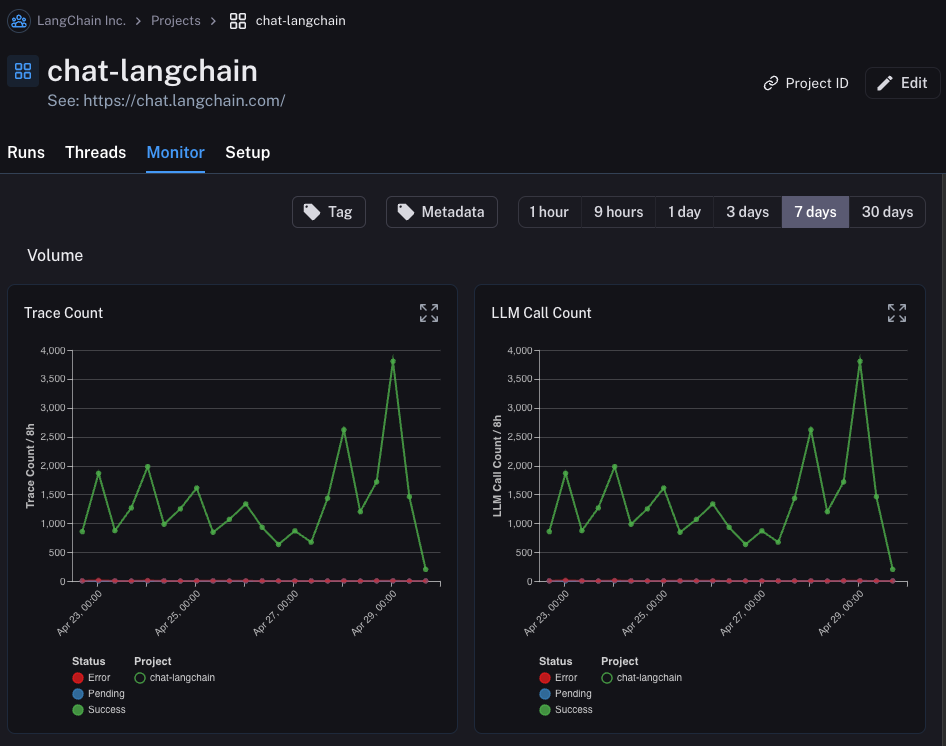

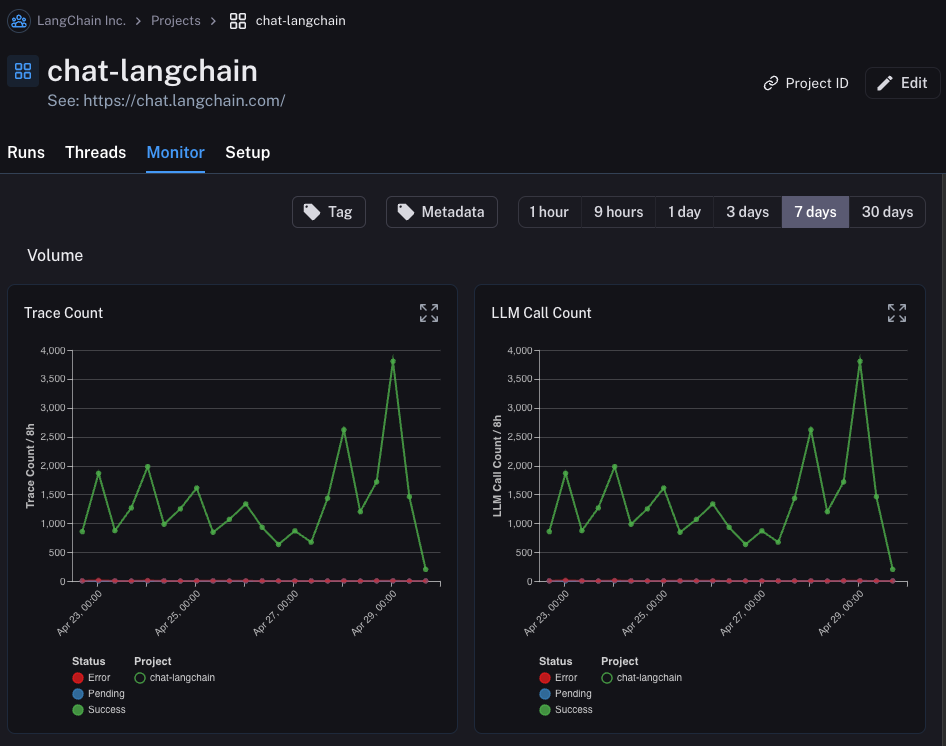

在生产中,您可能有更多的流量。所以您真的不想一次只查看一个数据点。幸运的是,LangSmith 有一套工具来帮助生产中的可观测性。

如果您在项目中单击

很好 - 您已经使用这种新发现的可观测性快速迭代,并对您的应用程序表现良好充满信心。是时候将其投入生产了!您需要添加什么新的可观测性?

首先,让我们注意,您已经添加的相同可观测性将继续在生产中提供价值。您将能够继续深入查看特定运行。

在生产中,您可能有更多的流量。所以您真的不想一次只查看一个数据点。幸运的是,LangSmith 有一套工具来帮助生产中的可观测性。

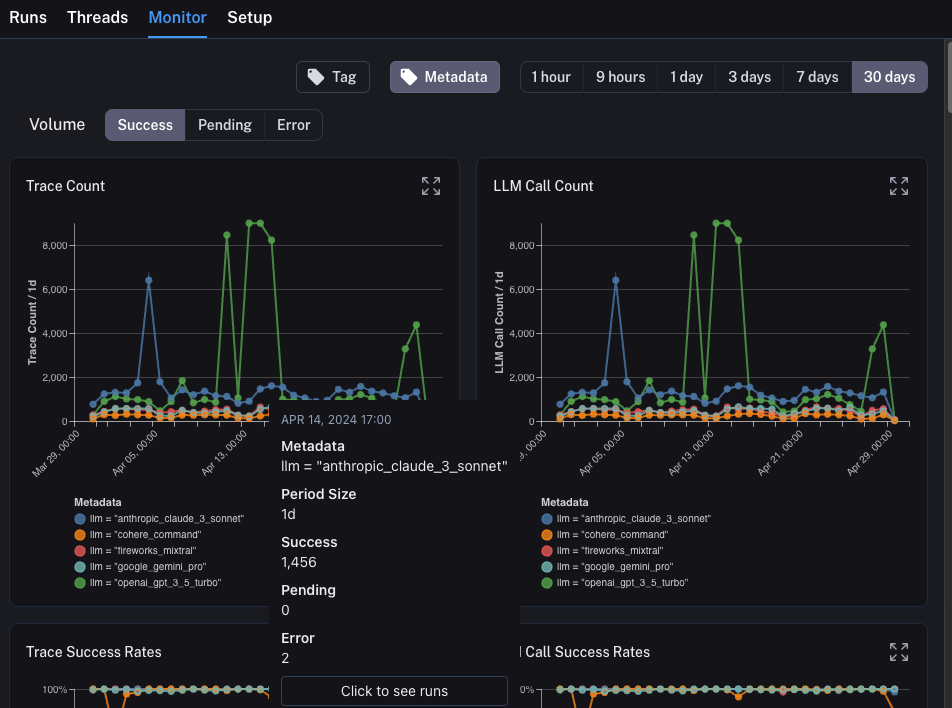

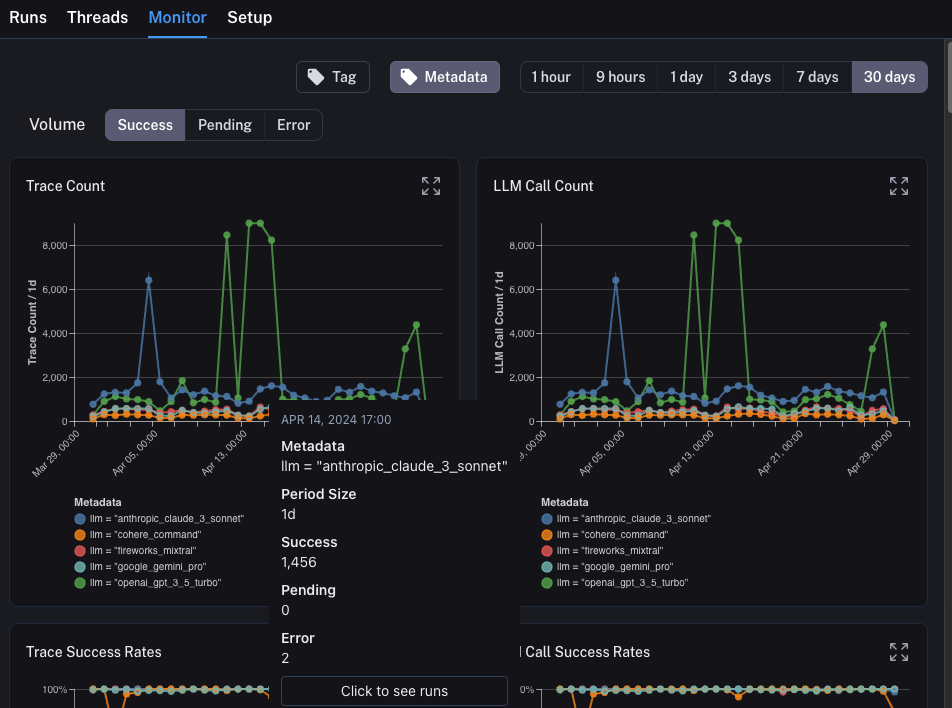

如果您在项目中单击 Monitor 选项卡,您将看到一系列监控图表。在这里,我们跟踪许多 LLM 特定统计信息 - 跟踪数量、反馈、首次令牌时间等。您可以在几个不同的时间范围内查看这些信息。

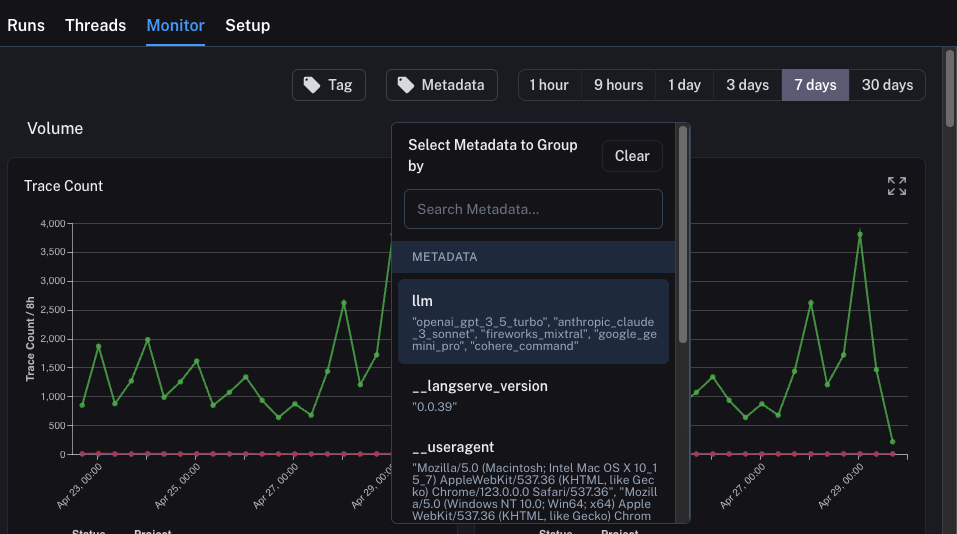

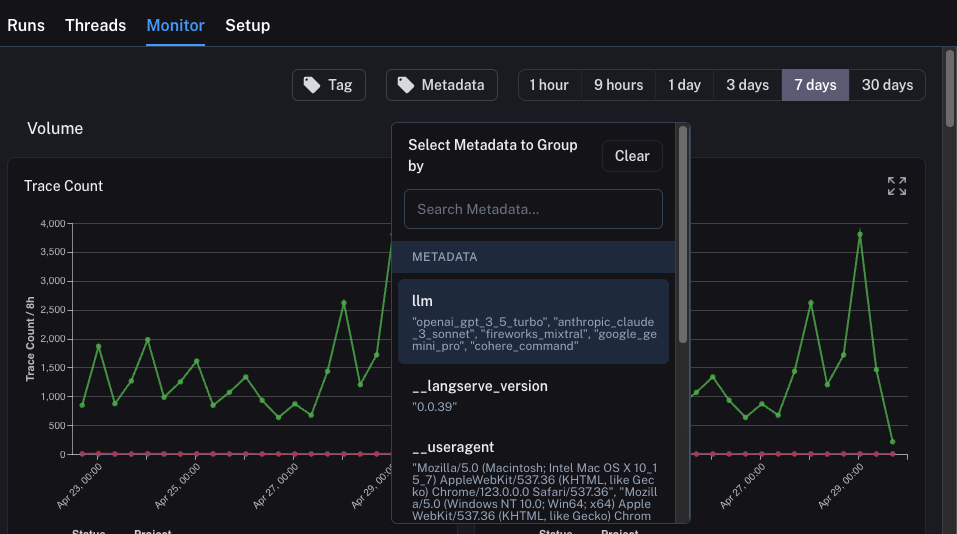

A/B 测试

A/B 测试的分组功能要求给定元数据键至少存在 2 个不同的值。

llm。我们可以按任何元数据属性对监控图表进行分组,并立即获得按时间分组的图表。这允许我们试验不同的 LLM(或提示,或其他)并跟踪它们随时间的性能。

为了做到这一点,我们只需要单击顶部的 Metadata 按钮。这将为我们提供一个下拉选项列表,用于选择分组依据:

一旦我们选择了这个,我们将开始看到按此属性分组的图表:

一旦我们选择了这个,我们将开始看到按此属性分组的图表:

深入分析

LangSmith 提供的出色能力之一是能够轻松深入分析您在查看监控图表时识别为有问题的数据点。为了做到这一点,您只需将鼠标悬停在监控图表中的数据点上。当您这样做时,您将能够单击数据点。这将带您回到带有过滤视图的运行表:

在本教程中,您看到了如何为 LLM 应用程序设置一流的可观测性。无论您的应用程序处于什么阶段,您仍然会从可观测性中受益。

如果您对可观测性有更深入的问题,请查看操作指南部分,了解有关测试、提示管理等主题的指南。

在本教程中,您看到了如何为 LLM 应用程序设置一流的可观测性。无论您的应用程序处于什么阶段,您仍然会从可观测性中受益。

如果您对可观测性有更深入的问题,请查看操作指南部分,了解有关测试、提示管理等主题的指南。

您还可以通过使用运行表中的过滤逻辑来查询所有具有正面(或负面)反馈的运行。您可以通过创建如下过滤器来做到这一点:

您还可以通过使用运行表中的过滤逻辑来查询所有具有正面(或负面)反馈的运行。您可以通过创建如下过滤器来做到这一点:

我们可以通过构建如下过滤器来过滤这些信息:

我们可以通过构建如下过滤器来过滤这些信息:

一旦我们选择了这个,我们将开始看到按此属性分组的图表:

一旦我们选择了这个,我们将开始看到按此属性分组的图表: