- 分析单个实验:查看和解释实验结果、自定义列、过滤数据和比较运行。

- 将实验结果下载为 CSV:导出实验数据以进行外部分析和共享。

- 重命名实验:在 Playground 和 Experiments 视图中更新实验名称。

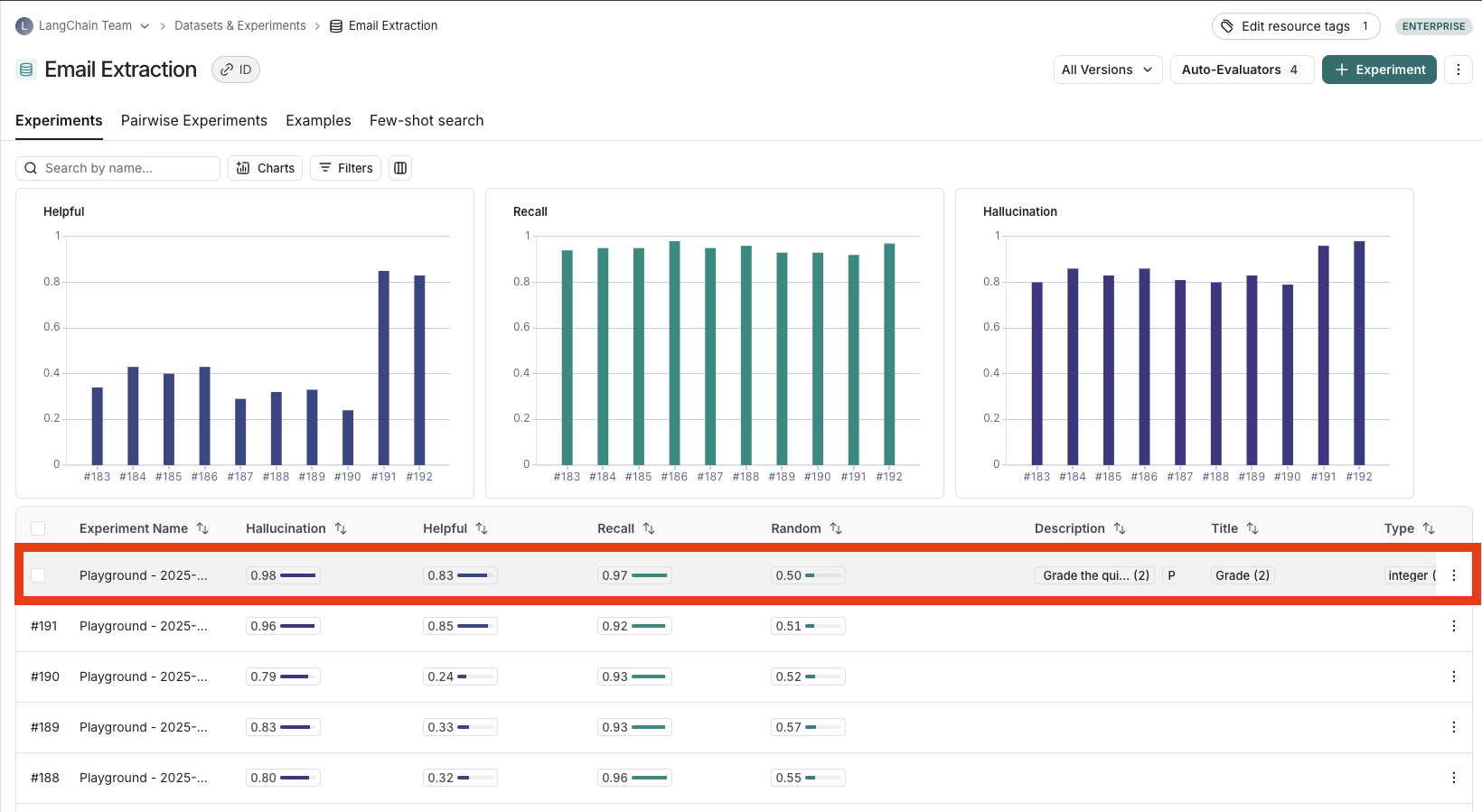

分析单个实验

运行实验后,您可以使用 LangSmith 的实验视图分析结果并了解实验性能的见解。打开实验视图

要打开实验视图,请从 Dataset & Experiments 页面选择相关的数据集,然后选择您要查看的实验。

查看实验结果

自定义列

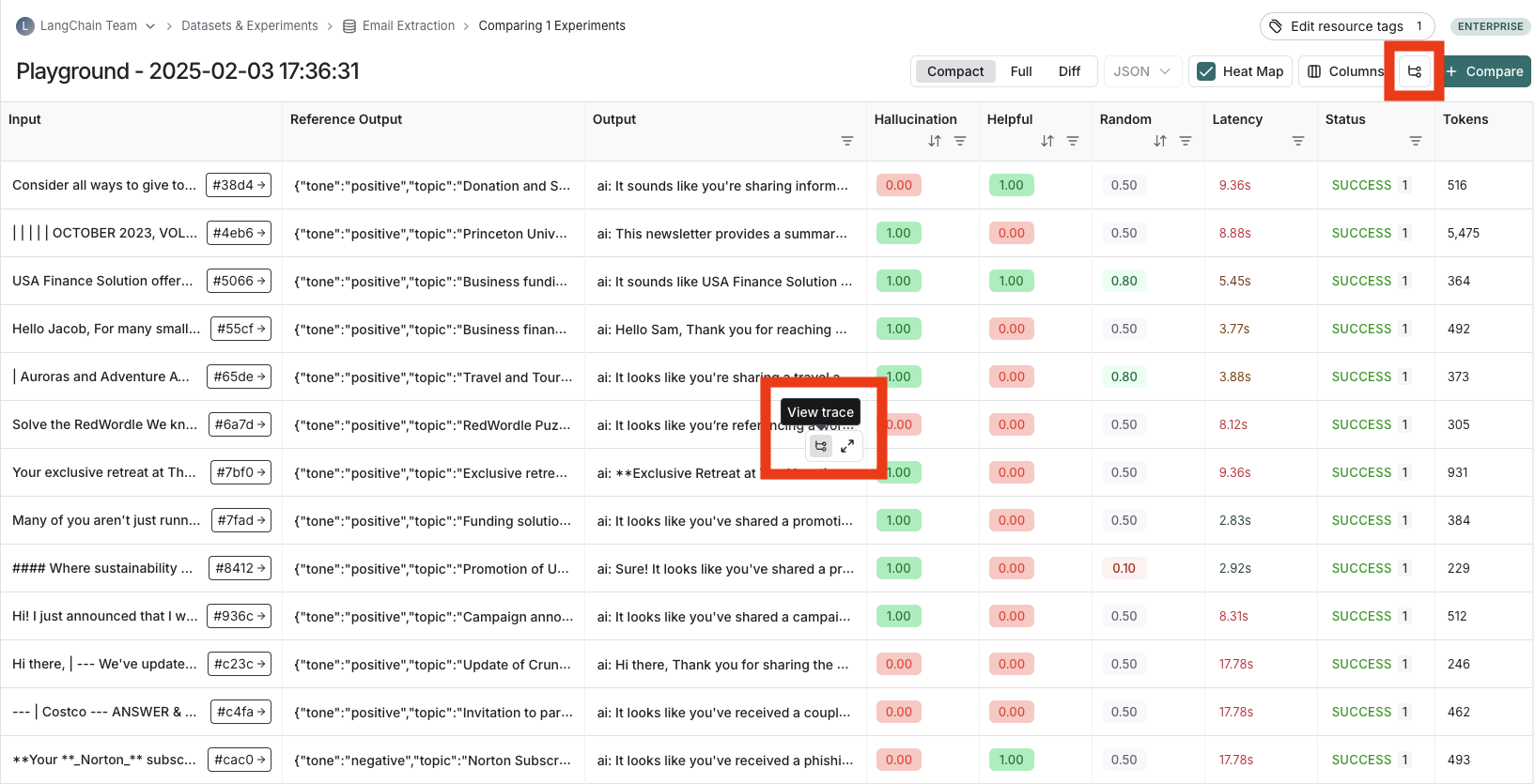

默认情况下,实验视图显示数据集中每个示例的输入、输出和参考输出、评估的反馈分数以及成本、令牌计数、延迟和状态等实验指标。 您可以使用 Display 按钮自定义列,以便更轻松地解释实验结果:- 将输入、输出和参考输出中的字段拆分到它们自己的列中。如果您有长的输入/输出/参考输出并希望显示重要字段,这特别有用。

- 隐藏和重新排序列以创建用于分析的重点视图。

- 控制反馈分数的小数精度。默认情况下,LangSmith 以小数精度 2 显示数值反馈分数,但您可以将此设置自定义为最多 6 位小数。

- 设置热图阈值为实验中数值反馈分数的高、中、低,这会影响分数芯片呈现为红色或绿色的阈值:

排序与筛选

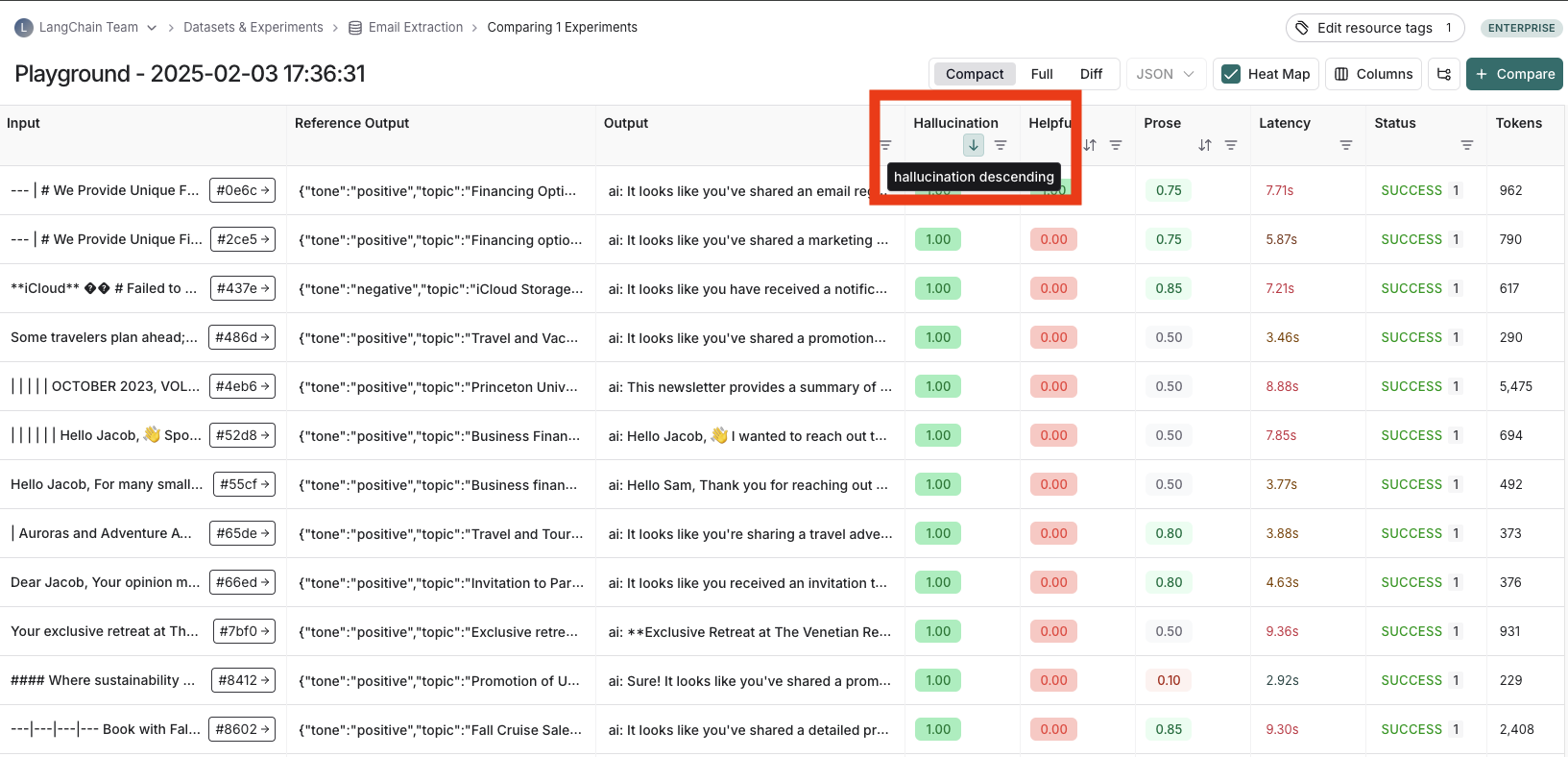

要对反馈分数排序或筛选,可使用列标题中的操作按钮。

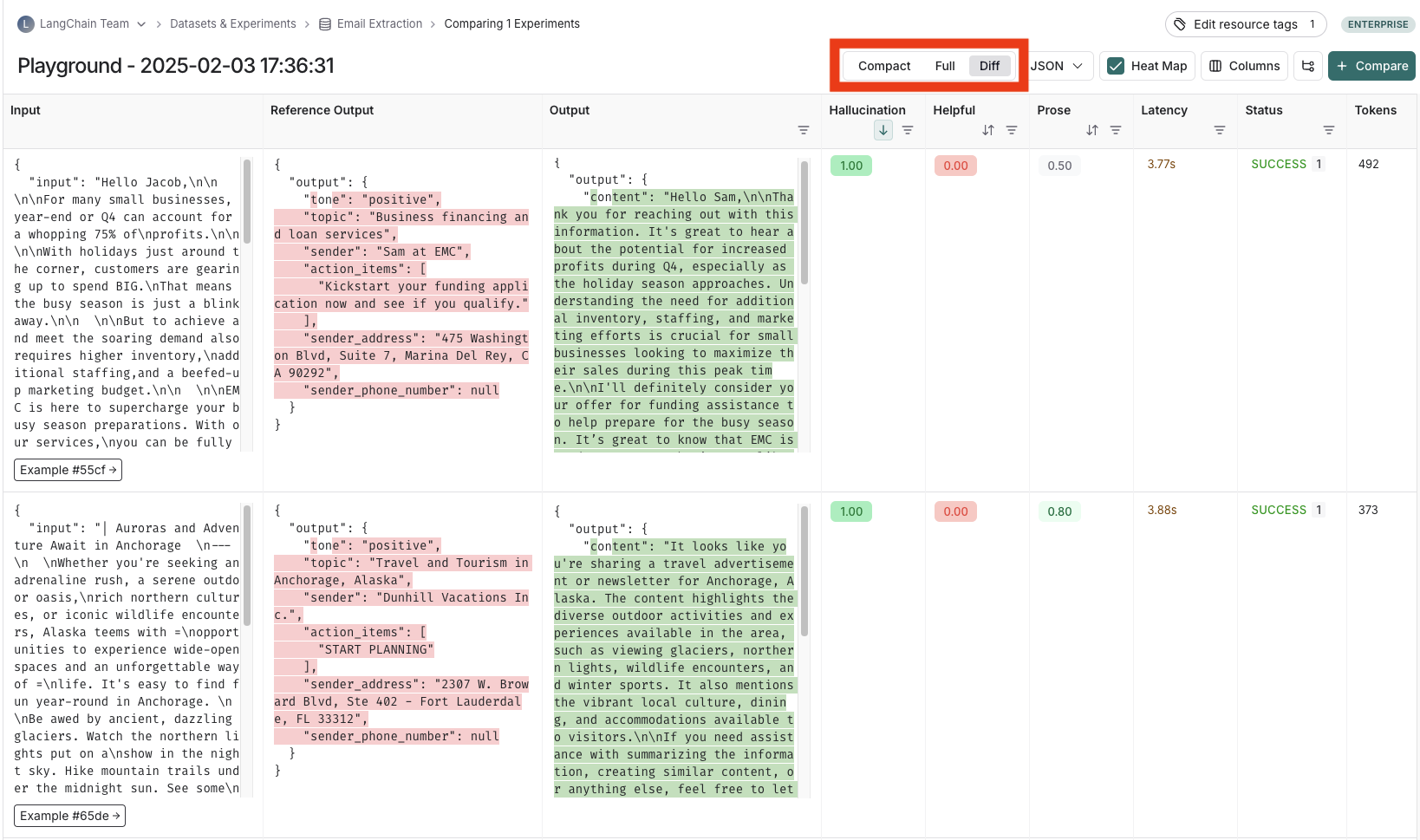

表格视图

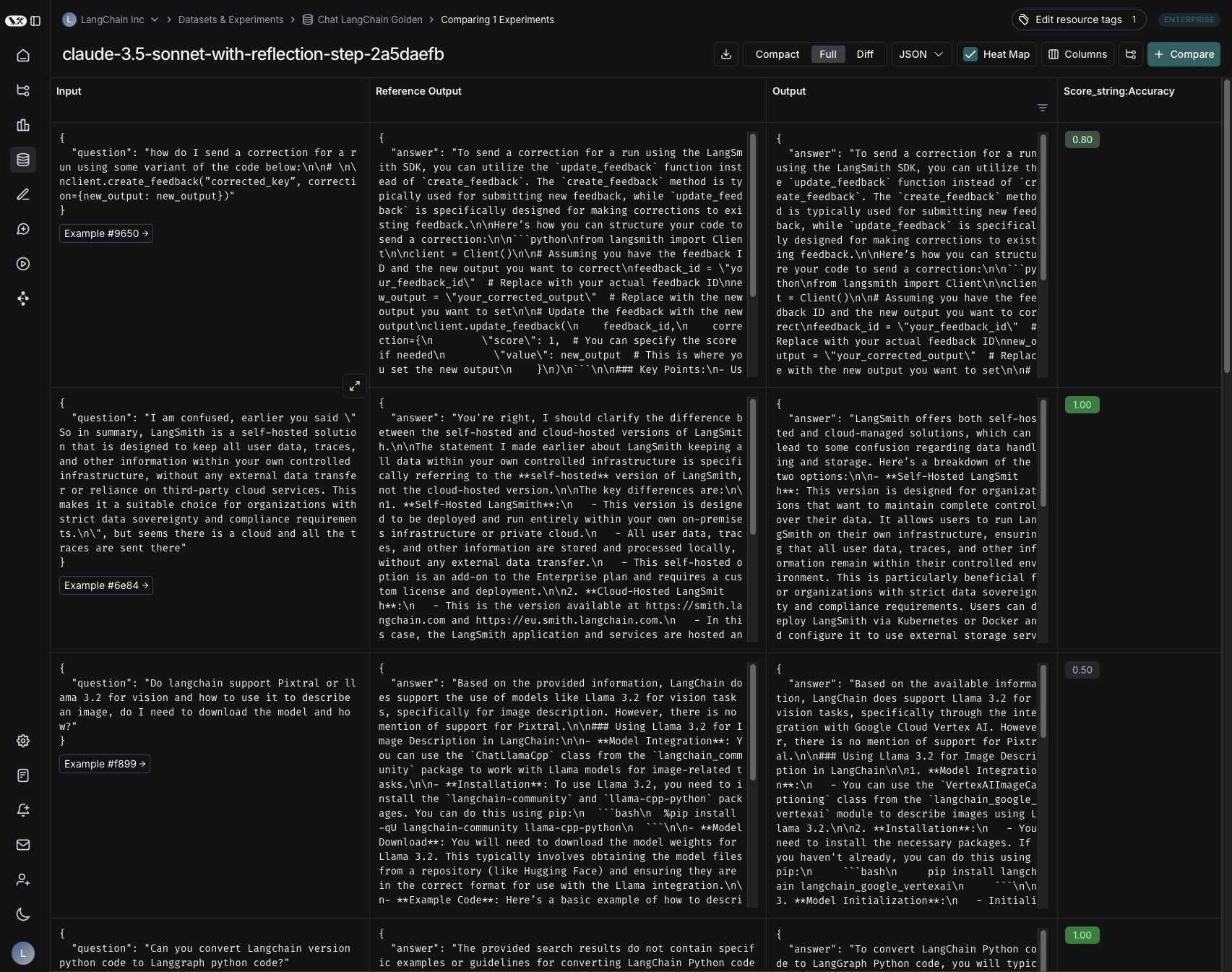

根据分析需求,可在紧凑、完整和差异三种视图间切换。- 紧凑视图:每个运行占一行,便于快速比较分数。

- 完整视图:展示每次运行的完整输出,方便深入查看细节。

- 差异视图:显示参考输出与实际输出的文本差异。

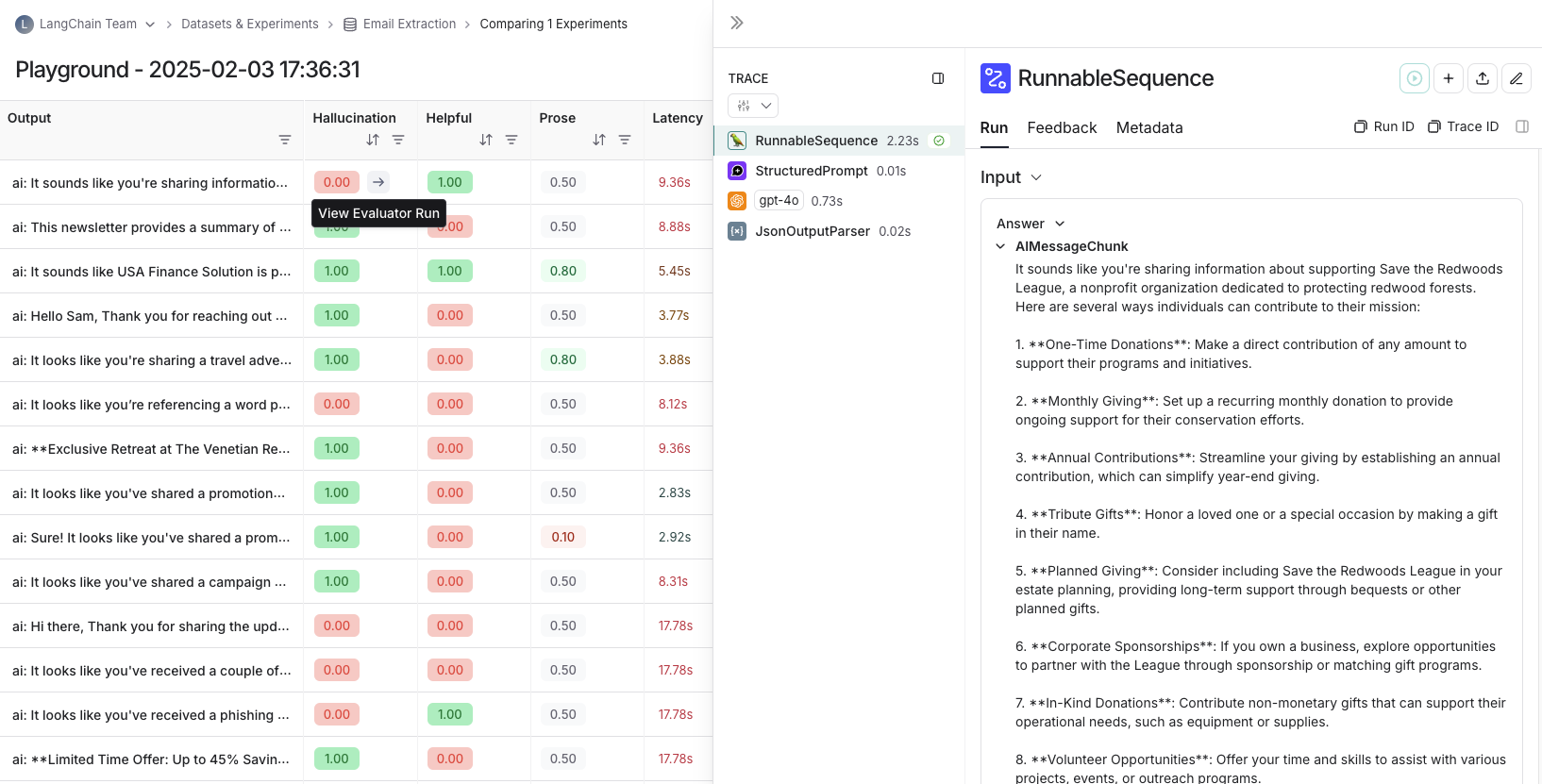

查看跟踪

将鼠标悬停在输出单元格上并点击跟踪图标即可打开对应运行的跟踪,结果会显示在侧边面板。 若想查看整个跟踪项目,可点击右上角的 View Project 按钮。

查看评估器运行

对于评估器分数,可悬停在分数单元格上并点击箭头图标以展开源运行,侧边面板会打开其跟踪。若使用 LLM-as-a-judge 评估器,还能查看该评估运行使用的提示;若实验包含重复运行,点击平均分即可跳转至每一次运行。

按元数据分组结果

可为示例添加元数据以进行分类,如在 QA 数据集中标记问题所属领域。元数据既可通过 UI 编辑,也能通过 SDK 更新。 在实验视图右上角的 Group by 下拉菜单选择元数据键,即可按组展示平均反馈分数、延迟、总 Token 和成本。仅 2025 年 2 月 20 日之后创建的实验支持按示例元数据分组;较早的实验仍可分组,但需元数据记录在实验跟踪上。

重复运行

若实验启用了重复,输出列会出现箭头,可在表格中展开各次运行。悬停并点击即可查看该重复中的所有输出。 启用重复时,LangSmith 会在表格中显示每项反馈分数的平均值。点击分数可查看各次运行的分数,或查看跨重复的标准差。

与其他实验对比

在实验视图右上角选择另一个实验即可进入对比视图,查看两次实验的差异。详情参阅比较实验结果。将实验结果导出为 CSV

LangSmith 支持将实验结果导出为 CSV 以便分析与分享。点击实验视图顶部的下载图标即可,该图标位于 Compact 视图开关左侧。

重命名实验

同一工作区内实验名称必须唯一。

-

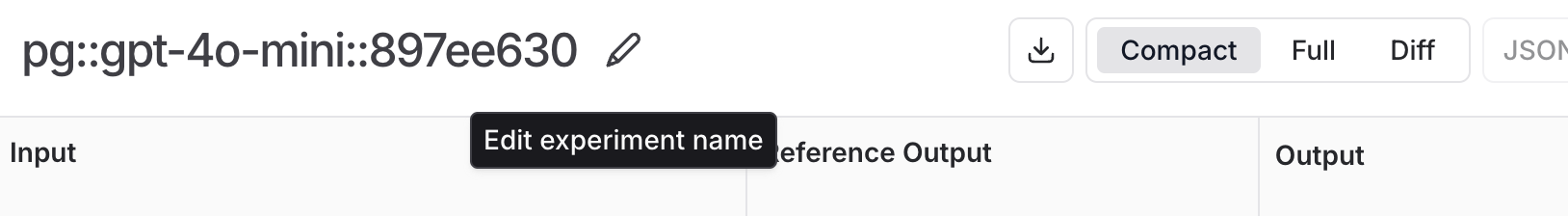

Playground:运行实验时默认命名格式为

pg::prompt-name::model::uuid(如pg::gpt-4o-mini::897ee630)。运行结束后可直接在表格标题处编辑名称。

-

Experiments 视图:查看实验结果时,可通过名称旁的铅笔图标修改。